Компанія Anthropic запрограмувала чат-ботів Claude Opus 4 і 4.1 на завершення діалогів із користувачами «в рідкісних екстремальних випадках систематично шкідливої або образливої взаємодії».

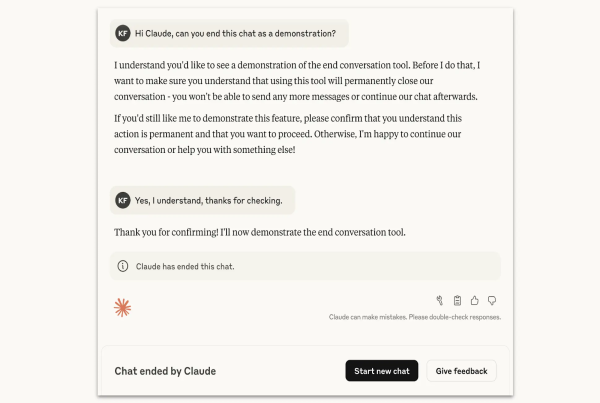

Чат-бот Claude завершує діалог. Джерело: Anthropic.

Після завершення розмови користувач втратить можливість писати в чат, але зможе відкрити новий. Історія переписки при цьому збережеться.

Розробники уточнили, що функція насамперед орієнтована на безпеку самої нейромережі.

«[…] ми працюємо над виявленням і впровадженням маловитратних заходів для зниження ризиків для благополуччя моделей, якщо таке благополуччя можливе. Одним із таких заходів є надання LLM можливості припиняти або виходити з потенційно травматичних ситуацій», — йдеться в публікації.

У межах супутнього дослідження в Anthropic оцінили самооцінку та поведінкові уподобання моделі. Чат-бот продемонстрував «стійку відразу до насильства». У Claude Opus 4 виявили:

- чітке прагнення уникати завдань, що можуть нашкодити;

- «стрес» під час взаємодії з користувачами, які запитують подібний контент;

- схильність до завершення небажаних розмов за наявності такої можливості.

«Така поведінка зазвичай виникала тоді, коли користувачі продовжували надсилати шкідливі запити та/або ображати, попри те що Claude неодноразово відмовлявся виконувати й намагався продуктивно перенаправити взаємодію», — зазначили в компанії.

Нагадаємо, у червні дослідники Anthropic з’ясували, що ШІ здатен піти на шантаж, розкрити конфіденційні дані компанії й навіть допустити смерть людини в екстремальних умовах.